LLMs: Cómo los Principios de Machine Learning Moldean el Futuro de la IA

La evolución de estos modelos no sería posible sin la aplicación rigurosa de conceptos como redes neuronales, entrenamiento supervisado y fine-tuning.

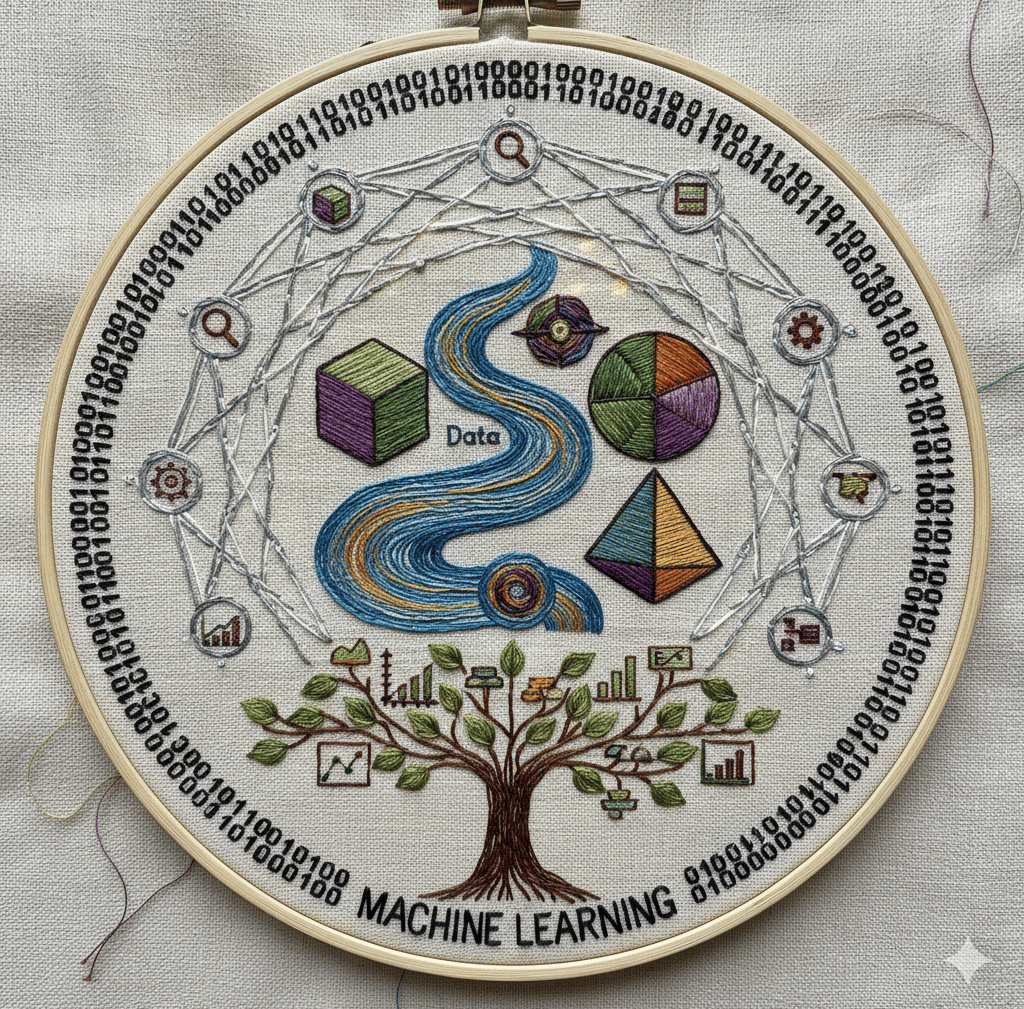

VIAJE DE INTELIGENCIA ARTIFICIAL

11/6/20253 min leer

Los Fundamentos de la Inteligencia: Cómo los Principios de Machine Learning Impulsan los Modelos de Lenguaje Grandes (LLMs)

El auge de los Modelos de Lenguaje Grandes (LLMs) como GPT-4 y Gemini ha cambiado el escenario de la tecnología para siempre. La capacidad de estos modelos para generar texto coherente, responder a preguntas complejas e incluso escribir código parece mágica, pero detrás de la "inteligencia" hay una base sólida de principios de machine learning. La evolución de estos modelos no sería posible sin la aplicación rigurosa de conceptos como redes neuronales, entrenamiento supervisado y fine-tuning. Comprender cómo estos fundamentos del machine learning se aplican a los LLMs es la clave para desvelar lo que realmente hace que la IA generativa sea tan poderosa y hacia dónde se dirige. Mientras la tecnología avanza rápidamente, es fundamental reflexionar sobre sus impactos en diversas áreas, garantizando que su implementación sea ética y beneficiosa para la sociedad.

El Papel de las Redes Neuronales y la Arquitectura Transformer

En el corazón de un LLM se encuentra una arquitectura de red neuronal, la estructura que simula el funcionamiento de un cerebro humano. Sin embargo, el gran salto evolutivo se produjo con la arquitectura Transformer, introducida en 2017. Antes de ella, los modelos de lenguaje procesaban el texto secuencialmente (palabra por palabra), lo que los hacía ineficientes para entender el contexto de frases largas. La implementación de esta nueva arquitectura trajo una revolución, permitiendo a los LLMs procesar información de manera más integrada y semántica.

El Transformer resolvió este problema con un mecanismo llamado "atención" (attention mechanism). En lugar de leer palabra por palabra, analiza todas las palabras de una frase a la vez, asignando un "peso" a cada una de ellas. Esto permite que el modelo entienda la relación entre palabras que están distantes en el texto. Por ejemplo, en una frase compleja, el Transformer sabe a qué se refiere un pronombre. Esta capacidad de procesar todo el contexto simultáneamente es la razón por la que los LLMs generan textos tan coherentes y contextualizados.

El Entrenamiento: La Fuerza Bruta del Machine Learning

El entrenamiento de un LLM es la aplicación a escala masiva de principios de machine learning. El proceso se puede dividir en dos etapas principales:

Preentrenamiento No Supervisado: Esta es la etapa de fuerza bruta. El modelo es alimentado con un volumen colosal de datos no etiquetados—billones de palabras de internet. El objetivo es que aprenda a predecir la siguiente palabra de una frase. Al hacer esto repetidamente, el modelo aprende la gramática, la sintaxis y la semántica del lenguaje humano, construyendo una vasta base de conocimiento sobre el mundo. Este proceso es "no supervisado" porque no requiere que un humano proporcione las respuestas correctas; el modelo aprende por sí solo.

Afinamiento (Fine-Tuning) Supervisado: Después del preentrenamiento, el modelo es una base de conocimiento genérica. Para hacerlo útil y seguro, pasa por un proceso de fine-tuning. Aquí, se utilizan datos de alta calidad con etiquetas humanas. Por ejemplo, los humanos pueden evaluar diferentes respuestas de IA a la misma pregunta, enseñando al modelo a ser más útil, conciso o creativo. Este proceso es "supervisado" porque los humanos "orientan" al modelo con base en la retroalimentación. Este fine-tuning es lo que transforma un modelo genérico en una herramienta específica para una tarea.

El Futuro de los LLMs y los Nuevos Desafíos del Machine Learning

Los LLMs están en el centro de un nuevo ciclo de innovación en machine learning. Los próximos desafíos no son solo sobre hacer los modelos más grandes, sino también más eficientes y confiables. La búsqueda de modelos más pequeños y especializados, que puedan ejecutarse en dispositivos móviles, es una de las principales tendencias. La superación de problemas como la "alucinación" (cuando la IA genera información falsa) y el sesgo en los datos de entrenamiento son desafíos que la comunidad está abordando activamente. A medida que estas tecnologías se integren más en nuestras vidas diarias, es esencial que los desarrolladores y investigadores se comprometan a construir sistemas que promuevan la equidad, accesibilidad y precisión de la información.

La evolución de los LLMs es la prueba viva de que la ingeniería de software y los principios de machine learning están intrínsecamente ligados. Cada avance en la arquitectura de red neuronal o en la técnica de entrenamiento impulsa la IA a nuevos niveles.

Innovación

Tecnología y Transformación Digital.

conexión

Aprendizaje

© 2025-2026. Todos los derechos reservados.